اقدامات اپل برای اسکن تلفن، طرفداران حریم خصوصی را نگران کرده است

کمپانی اپل سالهاست که بر افزودت برنامهها و ویژگیهای جدید به تلفنهای هوشمند خود تمرکز کرده است که تمامی آنها برای سهولت زندگی طراحی شدهاند. برای مثال، سیستمهای آن ایمیلها را برای قرارهای جدید تقویم اسکن میکنند و دستیار صوتی سیری هم پیشنهاد میکند در روز تولد دوستان خود تماس بگیرید؛ حالا اپل اقداماتی را برای محدود کردن انتشار محتویات سوء استفاده جنسی از کودکان (CSAM) را انجام میدهد که شامل اسکن عکس های ذخیره شده توسط کاربران آن می شود.

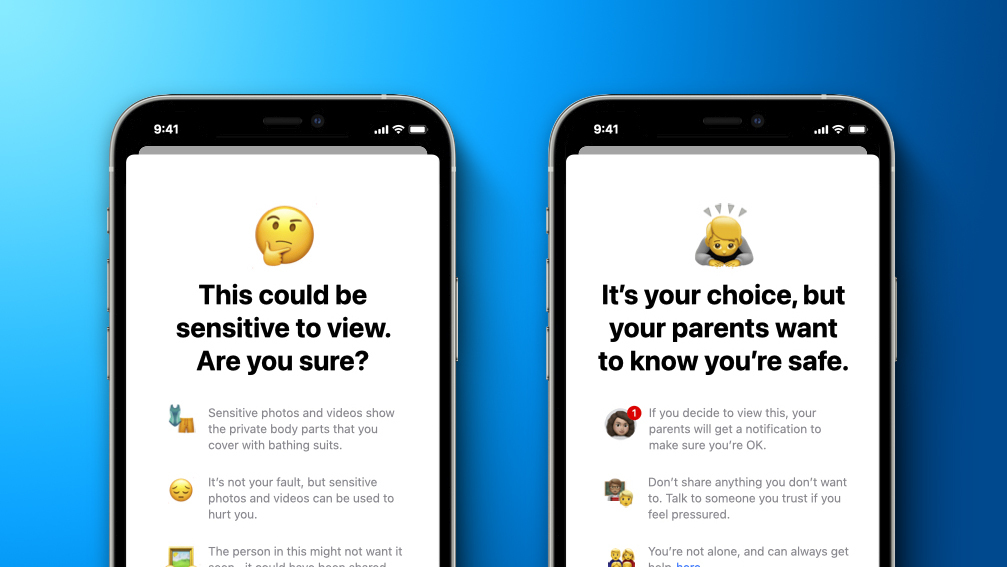

غول کوپرتینویی، در مطلب جدیدی که از وبسایت خود در روز پنجشنبه منتشر نمود، اظهار داشت که قصد دارد در نسخه جدید سیستمهای خود، قابلیت اسکن را که برای محدود کردن انتشار محتوای سوء استفاده جنسی از کودکان طراحی شده است، عرضه کند. اپل اعلام نمود که سیری و قابلیتهای جستجوی خود را بهروزرسانی میکند تا در برخی شرایط ناامن، اطلاعاتی را در اختیار والدین کودکان قرار دهد. همچنین این ویژگی، هنگام ارسال و یا دریافت تصاویر مستهجن در برنامه Messages، به والدین و فرزندان هشداری مبنی بر حساس بودن محتوای آن، خواهد داد.

کودکان میتوانند به هرحال با انتخاب “مشاهده تصویر” عکسها را ببینند، اما برای کودکان زیر 13 سال، والدین میتوانند در صورت کلیک کردن کودک برای مشاهده تصاویر تار شده، اعلان هشدار دریافت نمایند. اعلانهای والدین اختیاری است و تنها زمانی قابل دسترس است که کودک کمتر از 13 سال سن داشته باشد و امکان فعال سازی این ویژگی برای کودکان بالای 13 سال وجود ندارد.

در ادامه به نحوه عملکرد این ویژگی از زبان اپل میپردازیم:

اپل با فناوری جدید خود تصاویر ارسالی و ذخیره شده در اپلیکیشن Photos را با استفاده از پایگاه دادهای از هشهای شناخته شده CSAM که توسط مرکز ملی کودکان مفقود و سایر سازمانهای ایمنی کودک ارائه شده است، شناسایی میکند. به گفته کوپرتینوییها این سیستم بهصورت خودکار و با در نظر داشتن حریم خصوصی کاربران طراحی شده است، زیرا سیستم قبل از پشتیبان گیری از تصاویر آیکلود روی دستگاه، تصاویر را اسکن میکند. اگر برنامه تشخیص دهد که تصاویر برخلاف قوانین ذکر شده هستند، تصاویر را بصورت خودکار به نمایندگان اپل ارسال میکند تا اقدامات لازم صورت بگیرد. اپل همچنین این پایگاه داده را به مجموعهای از هشهای ناخوانا تبدیل میکند که به طور ایمن در دستگاههای کاربران ذخیره میشود.

قبل از ذخیره تصاویر در iCloud Photos، فرآیندی برای تطبیق تصاویر در هشهای شناخته شده CSAM انجام میشود. این فرآیند تطبیق با یک فناوری رمزنگاری به نام “private set intersection” تنظیم میشود، که تعیین میکند آیا تصویر ذخیره شده با هشها مطابقت دارند یا خیر، و دستگاه بدون نمایش نتیجه، یک ووچر رمزنگاری شده را ایجاد کرده و به همراه تصویر در iCloud Photos بارگزاری میکند.

با استفاده فناوری دیگری تحت عنوان “threshold secret sharing” این سیستم اطمینان میدهد که محتویات ووچر تا زمانی که به عنوان محتوای CSAM شناخته نشود، توسط اپل قابل شناسایی نخواهد بود. این فناوری، میزان بسیاری بالایی از دقت را ارائه میدهد و به ادعای اپل، احتمال خطای آن کمتر از یک در تریلیون در سال میباشد!

تنها در صورتی که محتوای تصاویر از محدوده مشخص شده فراتر رود، اپل امکان تطابق ووچرهای ایمنی با تصاویر CSAM راه خواهد داشت؛ پس از بررسی گزارشات، در صورتی که تصاویر، محتوای CSAM شناخته شوند، حساب کاربری شخص غیرفعال شده و گزارشات به سازمان NCMEC ارسال میشود.

در نهایت، این فناوری نوآورانه به اپل اجازه میدهد تا اطلاعاتی ارزشمند و کاربردی درباره محتویات CSAM را در اختیار سازمان NCMEC و مجریان قانون قرار دهد. این نکته قابل توجه است که، اپل تنها در صورت به تصاویر کاربران دسترسی خواهد داشت که آنها مجموعهای از CSAM شناخته شده را در حساب iCloud Photos خود داشته باشند؛ حتی در این شرایط نیز، اپل تنها تصاویر که محتوای CSAM شناخته شدهاند دسترسی خواهد داشت.

درحالی که بسیاری از افراد از تلاشهای اپل برای اقدامات آن درباره کودکان استقبال میکردند، آنها همچنین نگران بودند که این غول فناوری ممکن است سیستمی را ایجاد کند که در نهایت مورد سو استفاده بسیاری از رژیمها قرار گیرد. چرا که اخیرا بدافزار پگاسوس که به عنوان ابزاری برای مبارزه با جنایتکاران و تروریستها معرفی میشود، برای هک 50 هزار شماره تلفن متصل به فعالات، رهبران دولتی، روزنامه نگاران، وکلا و معلمان در سراسر جهان مورد استفاده قرار گرفته است.

متیو گرین، پروفسور دانشگاه جان هاپکینز که در زمینه فناوریهای رمزنگاری فعالیت میکند، در توییتی اظهار داشت:

حتی اگر فکر میکنید که اپل اجازه سو استفاده از این ابزارها را نخواهد داد، هنوز هم جای نگرانی وجود دارد.

همچنین الک مافت، محقق امنیتی، در توییتی نوشت:

مطلقا مهمترین داستانی که یک شبه رخ داد این است که ظاهرا اپل قصد دارد ویژگیای را برای تشخیص تصاویر و نظارت دولتی بر روی آیفونهای همه کاربران به نام محافظت از کودکان راه اندازی کند.

بسیاری از شرکتهای فناوری نیز، سالهاست که تصاویر را اسکن میکنند. کمپانیهای فیسبوک و توییتر هردو با بسیاری از سازمانهای مشابه، برای مبارزه با انتشار تصاویر نامناسب از کودکان در شبکههای اجتماعی، همکاری کردهاند. اما آنچه اپل را متفاوت میکند، این است برخلاف دیگر کمپانیها که تصاویر را پس از بارگذاری در اینترنت اسکن میکنند، اپل آنها را بر روی دستگاههای خود اسکن میکند.